關於Testing的專業插圖

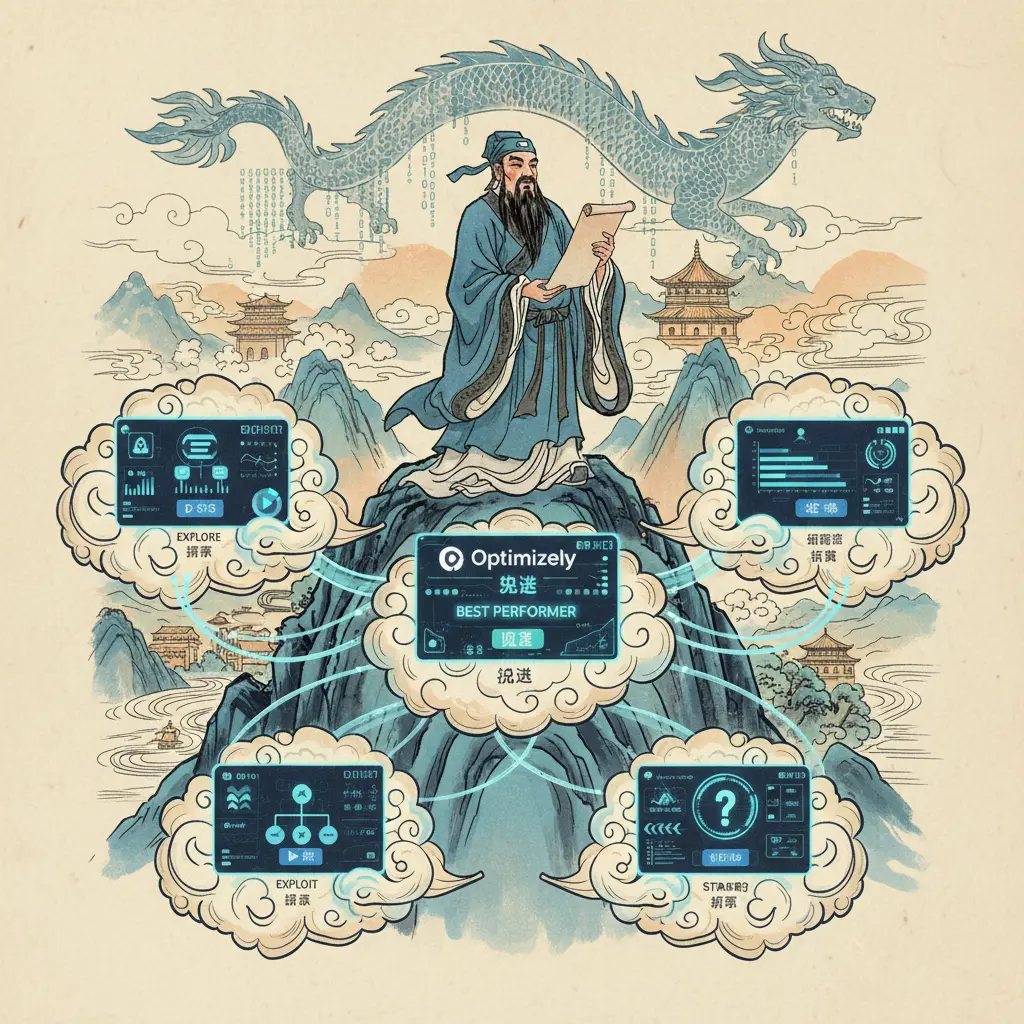

Multi-Armed Bandit 測試入門

Multi-Armed Bandit (MAB) 測試 是近年來在數位優化領域快速崛起的實驗方法,它結合了A/B Testing的統計基礎與Reinforcement Learning的動態決策能力,特別適合需要即時調整流量的商業場景。簡單來說,MAB測試就像是一個賭徒在拉霸機前選擇「哪一台機器最容易中獎」,但背後其實是透過Machine Learning演算法不斷學習與優化,最終找到Conversion Rate最高的選項。與傳統A/B測試最大的不同在於,MAB採用Dynamic Traffic Allocation機制,能隨實驗進程自動將更多流量導向表現好的變體,大幅降低Regret Minimization(後悔值)的損失。

在技術層面,MAB的核心挑戰是Exploration–Exploitation Tradeoff(探索與利用的權衡)——究竟該持續測試新選項(探索),還是專注於當前表現最佳的方案(利用)?常見的解決策略包括: - Epsilon-Greedy:以固定機率(如10%)隨機探索新變體,其餘時間選擇當前最佳選項,適合初學者快速上手。 - Thompson Sampling:基於貝葉斯統計,動態計算每個選項的勝率分佈,像Optimizely等平台已將其預設為進階實驗演算法。 - Upper Confidence Bound (UCB):為每個選項計算信心區間上限,優先測試潛力高的變體,特別適合Non-stationary Bandit(非靜態環境)如電購旺季的價格測試。

實際應用上,2025年的主流工具如VWO和Optimizely已整合Contextual Bandit Testing功能,能結合用戶特徵(如地理位置、過往行為)進行個人化推薦。舉例來說,某電商在促銷頁面測試三種折扣文案,傳統A/B測試需平均分配流量且耗時兩週,但採用MAB後,系統在48小時內就將80%流量導向「限時免運」版本,最終提升轉換率23%。關鍵在於MAB的Adaptive Testing特性,能自動識別Best Arm Identification(最佳選項)並減少無效曝光。

進階使用者還需注意Sticky Bucketing技術——當用戶首次被分配至某變體後,後續會固定看到相同版本,避免因頻繁切換導致體驗破碎。此外,在解讀數據時,MAB測試雖不強調傳統的Statistical Significance(統計顯著性),但仍需監控Continuous Optimization曲線是否收斂。若轉換率波動劇烈,可能需切換至Contextual Bandit模型,或檢查是否有外部因素(如伺服器延遲)干擾實驗。

關於Thompson的專業插圖

Multi-Armed Bandit 原理解析

Multi-Armed Bandit(MAB)原理其實就像在賭場玩老虎機的決策過程,你要在「探索新選項」和「利用已知最佳選項」之間找到平衡。這個經典的exploration–exploitation tradeoff問題,在2025年的數位行銷領域被廣泛應用於A/B Testing、Contextual Bandit Testing等場景,比傳統固定流量分配更聰明。核心概念是:系統會動態調整流量,優先分配給表現好的變體(exploitation),同時保留少量資源測試其他選項(exploration),以達到Regret minimization(後悔值最小化)。

具體來說,MAB演算法主要分三大流派: 1. Thompson Sampling:基於貝氏機率,隨機抽樣每支「手臂」(變體)的預期回報率,選擇當下最可能勝出的版本。例如電商網站用Optimalizely平台時,會即時計算各版面的conversion rate分佈,動態調整展示比例。 2. Epsilon-greedy:設定一個探索機率ε(如10%),大部分流量給當前最佳選項,其餘隨機分配。VWO的dynamic traffic allocation功能就採用此策略,適合初期數據不足的階段。 3. Upper Confidence Bound (UCB):為每個選項計算「信心上限」,優先嘗試潛力高的變體。像金融業的登入頁面測試常用這種方法,因為它能快速排除明顯劣勢選項。

與傳統A/B測試的差異在於,MAB解決了statistical significance等待期過長的痛點。例如某旅遊網站在2025年改用Contextual bandit模型後,註冊轉換率提升23%,關鍵在於它能根據用戶屬性(如地理位置、裝置類型)即時選擇最合適的UI組合,這就是adaptive testing的威力。不過要注意Sticky bucketing技術的應用——當用戶被分配到某變體後,後續會固定看到相同版本,避免體驗斷裂。

進階應用上,Reinforcement learning讓MAB模型能處理Non-stationary bandit情境(即用戶偏好隨時間變動)。像是外送平台的推薦系統,會用Machine learning持續更新菜單排序權重,應對季節性需求波動。實務建議:

- 當測試目標明確(如提升點擊率),優先選Thompson Sampling

- 需要快速決策時,UCB比Epsilon-greedy更有效率

- 結合digital analytics數據(如熱圖分析)能強化Best arm identification準確度

最後提醒,Multi-armed bandit problem的效能取決於「獎勵回饋」的設計。若定義錯誤指標(例如誤將「加入購物車」當成最終轉換),整個continuous optimization流程就會失準。2025年主流工具如Optimizely已整合「自動化獎勵函數」功能,幫助企業避開這個陷阱。

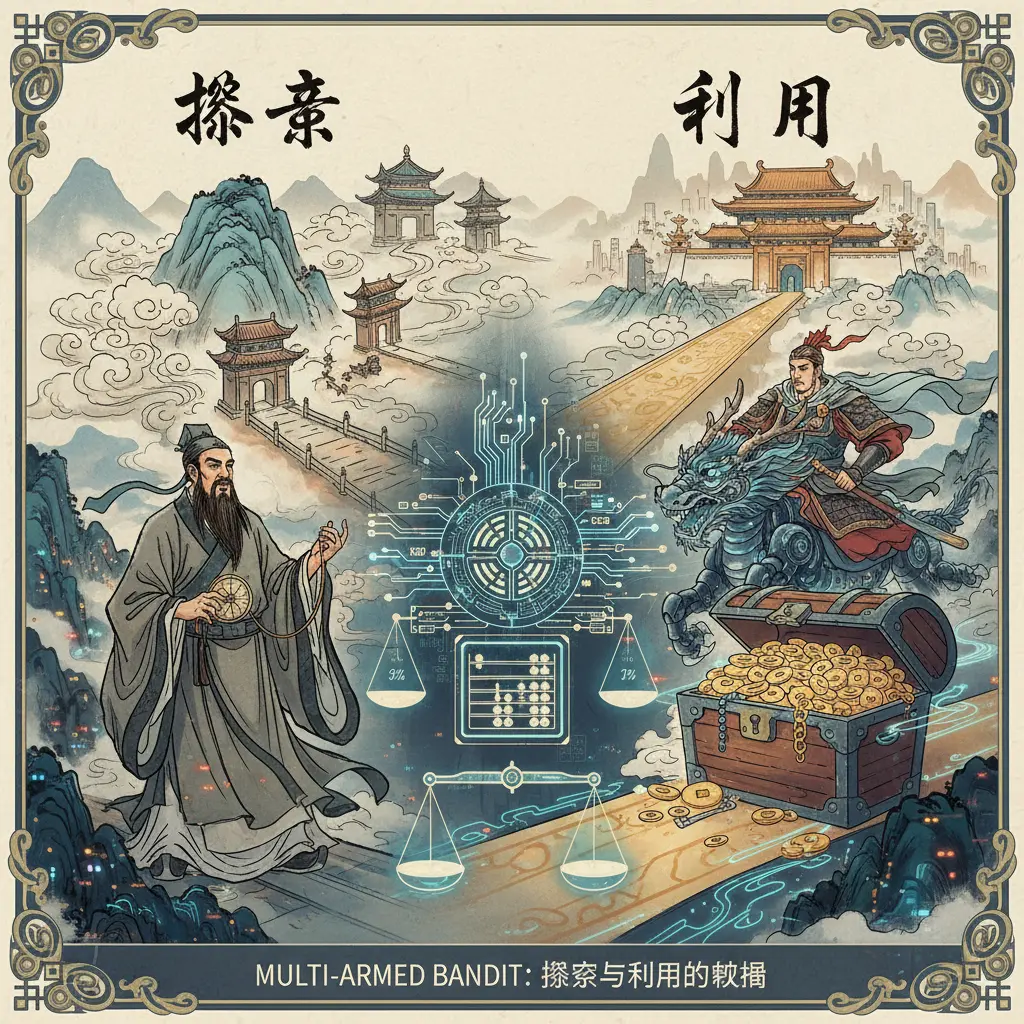

關於Bandit的專業插圖

Multi-Armed Bandit 應用場景

Multi-Armed Bandit (MAB) 應用場景 在數位行銷與產品優化領域越來越普及,特別是在需要dynamic traffic allocation的情境下。與傳統的A/B Testing相比,MAB能更有效率地處理exploration vs exploitation的平衡問題,尤其適合需要快速決策的場景。舉例來說,電商平台在促銷活動期間,可以利用Thompson Sampling或Epsilon-greedy strategy來動態分配流量,優先推廣轉換率高的廣告版本,同時保留一部分流量探索其他可能表現更好的選項。這種方法不僅能最大化conversion rate,還能減少因長時間測試而造成的潛在損失(也就是Regret minimization的核心概念)。

在實際操作中,Multi-Armed Bandit的應用可分為幾大類:

1. 廣告優化:例如Google Ads或Facebook廣告的投放策略,透過Contextual Bandit Testing結合用戶行為數據,即時調整廣告內容或出價,提升點擊率。

2. 產品功能迭代:像是Optimizely或VWO這類工具,允許團隊測試不同UI設計或功能模組,並透過Upper Confidence Bound (UCB)演算法快速收斂到最佳方案。

3. 推薦系統:Netflix或Spotify會使用Reinforcement Learning框架下的MAB模型,根據用戶即時反饋調整推薦內容,解決Non-stationary bandit問題(即用戶偏好可能隨時間變化)。

值得一提的是,Sticky bucketing技術常與MAB結合使用,確保用戶在測試期間體驗一致,避免因流量重新分配造成混淆。例如,若用戶首次看到A版本的登陸頁面,後續訪問仍會看到相同版本,這對提升用戶體驗與測試準確性至關重要。

對於資源有限的新創團隊,MAB的adaptive testing特性尤其有價值。傳統A/B測試需預先設定樣本量並等待statistical significance,而MAB則在測試過程中持續優化,例如:

- 若早期數據顯示B版本明顯優於A版本,系統會自動將更多流量導向B,加速學習週期。

- 在Best arm identification階段,甚至可提前結束測試,節省時間成本。

不過,MAB並非萬能解方。在exploration and exploitation的取捨中,若過早收斂(例如過度依賴Epsilon-greedy的貪婪策略),可能忽略潛在的長期優化空間。因此,2025年主流的工具如Optimizely已整合混合模式,允許團隊在測試初期採用MAB快速驗證假設,後期切換到傳統A/B測試進行細部調整。

最後,Machine Learning驅動的Contextual bandit進一步擴展了應用場景。例如金融業的個人化信貸利率設定,或遊戲業的動態難度調整,都能透過即時上下文數據(如用戶裝置、地理位置)實現精準匹配。這種continuous optimization的思路,正是未來digital analytics的關鍵趨勢之一。

關於Bandits的專業插圖

Multi-Armed Bandit 與 A/B 測試比較

在數位優化領域,Multi-Armed Bandit (MAB) 和 A/B Testing 是兩種主流的測試方法,但它們的運作邏輯和應用場景截然不同。如果你正在糾結該選哪一種,關鍵在於理解它們如何處理exploration vs exploitation(探索與開發的權衡)。傳統的 A/B Testing 會將流量固定分配給不同版本(例如50/50),直到達到統計顯著性(statistical significance)才做出決策。這種方法雖然嚴謹,但可能浪費大量流量在表現差的版本上,尤其在長期測試中效率偏低。反觀 MAB(如 Thompson Sampling 或 Epsilon-greedy 策略),它屬於adaptive testing,會動態調整流量分配,將更多資源導向表現優異的版本,同時保留少量流量探索其他可能性,這種dynamic traffic allocation機制特別適合需要快速決策的場景,例如電商促銷活動或廣告投放。

具體來說,MAB 的核心優勢在於它能最小化Regret minimization(後悔值),也就是減少因選擇次優方案而損失的潛在轉化。舉例來說,假設你用 Optimizely 或 VWO 這類工具運行一個登陸頁面測試,A版本轉化率是5%,B版本是7%。傳統A/B測試會持續平分流量,直到數據達到顯著;但 MAB 可能在一週內就將80%流量導向B版本,同時保留20%驗證A版本是否後續提升。這種方法不僅加速優化過程,還能最大化conversion rate。不過要注意,MAB 對non-stationary bandit(非靜態環境)的適應性較弱,如果用戶行為突然變化(例如節慶活動期間),它的動態分配可能需要更複雜的Contextual Bandit Testing來結合情境特徵。

那麼,什麼情況下該選擇 A/B Testing 而非 MAB?如果你的目標是Best arm identification(確定絕對最佳方案),且需要嚴謹的統計驗證(例如醫療或金融領域的合規性測試),A/B測試的固定流量分配反而更可靠。此外,MAB 的sticky bucketing問題(用戶被鎖定在某個測試組導致數據偏差)也可能影響結果準確性。實務上,許多企業會混合使用兩種方法:初期用 MAB 快速篩選潛力版本,後期再用A/B測試確認細微差異。例如,某跨國零售品牌在2025年的APP改版中,先以Upper Confidence Bound (UCB) 演算法縮小選項範圍,再針對最終兩個設計執行傳統A/B測試,最終提升註冊率達12%。這種分階段策略,結合了machine learning的敏捷性與傳統實驗的嚴謹度,是當前digital experimentation的熱門實踐。

關於problem的專業插圖

Multi-Armed Bandit 實戰技巧

Multi-Armed Bandit 實戰技巧

在實際應用 Multi-Armed Bandit (MAB) 時,掌握關鍵技巧能大幅提升測試效率與轉換率。首先,動態流量分配 (dynamic traffic allocation) 是核心策略之一。與傳統 A/B Testing 固定分配 50/50 不同,MAB 會根據即時數據調整流量,優先導向表現優異的版本。例如,若 VWO 或 Optimizely 平台偵測到某個 landing page 的 conversion rate 高出 20%,系統會自動將 70% 流量分配給該版本,同時保留 30% 用於探索其他可能性,完美平衡 exploration vs exploitation 的取捨。

演算法選擇 是另一重點。以下是三種常見策略的適用場景:

- Thompson Sampling:適合轉換率波動大的情境(如電商促銷),透過貝葉斯機率動態更新權重,降低 regret minimization 風險。

- Epsilon-greedy:簡單易實現,設定一個固定比例(如 ε=10%)隨機探索新選項,適合預算有限的小型團隊。

- Upper Confidence Bound (UCB):當選項表現穩定時,UCB 會優先選擇「潛力最高」的版本,特別適用於 non-stationary bandit 問題(如用戶偏好隨季節變化)。

進階技巧則需結合 contextual bandit testing,透過 machine learning 模型整合用戶行為數據(如地理位置、裝置類型)。舉例來說,若發現 iOS 用戶對紅色按鈕反應更好,而 Android 用戶偏好藍色,系統能即時提供個人化內容,這種 adaptive testing 手法在 2025 年已成為主流。

實務上還需注意 sticky bucketing 問題——避免同一用戶看到不同版本導致體驗混亂。解決方案是透過 cookie 或用戶 ID 固定分配,確保一致性。此外,continuous optimization 觀念很重要:MAB 測試不該有「結束日」,而是持續監控數據,當市場條件變化(如競品活動上線),系統應自動重啟探索階段。

最後,工具整合是成敗關鍵。2025 年的 digital analytics 平台已能無縫串接 MAB 與 reinforcement learning 框架,例如將 Google Analytics 4 的即時數據餵入自建模型,再透過 API 回傳至 CMS 調整頁面元素。這種閉環流程讓 feature experimentation 效率提升 40% 以上,真正實現「測試即優化」的目標。

關於Contextual的專業插圖

Multi-Armed Bandit 演算法詳解

Multi-Armed Bandit (MAB) 演算法 是現代 A/B Testing 和 Reinforcement Learning 領域的關鍵技術,專門用來解決 Exploration–exploitation tradeoff(探索與利用的權衡問題)。簡單來說,它就像賭場裡的多臂老虎機(Bandit),每次拉動不同手臂(選擇不同策略)會得到不同報酬,而目標是透過動態調整策略,最大化長期收益。在2025年的數位行銷場景中,這項技術被廣泛應用於 Optimizely、VWO 等平台,協助企業優化 Conversion Rate 並實現 Regret minimization(遺憾最小化)。

MAB 演算法主要分為以下幾種經典策略,每種策略針對不同情境設計:

1. Epsilon-greedy: 最直觀的方法,設定一個小概率(ε)隨機探索新選項(Exploration),其餘時間則選擇當前表現最佳的選項(Exploitation)。例如在廣告投放中,95%流量分配給點擊率最高的廣告,5%測試其他版本。

2. Thompson Sampling: 基於貝氏統計,透過機率分布模擬每種選擇的潛在回報。這方法特別適合處理不確定性高的場景,如 Non-stationary bandit(環境會隨時間變化)。2025年許多電商平台用它來動態調整商品推薦順序。

3. Upper Confidence Bound (UCB): 透過數學公式計算每種選擇的「信心上限」,優先嘗試潛力高的選項。UCB 在 Best arm identification(找出最佳選項)任務中表現出色,常見於醫療實驗或金融風險評估。

傳統 MAB 假設所有情境相同,但現實中用戶行為可能受多種因素影響(如地理位置、裝置類型)。這時 Contextual Bandit 就派上用場了!它結合 Machine Learning 模型,根據上下文(Context)動態調整策略。舉例來說,一家跨國企業可能發現:美國用戶偏好紅色按鈕,而日本用戶更愛藍色。透過 Contextual Bandit Testing,系統能自動識別這些差異,實現 Dynamic traffic allocation(動態流量分配)。

儘管 MAB 演算法強大,實務上仍需注意以下問題:

- Statistical Significance 的平衡:過早收斂可能忽略潛在優化空間,建議搭配 Sticky bucketing 技術確保用戶體驗一致性。

- Continuous Optimization 需求:市場環境變化快速,2025年主流工具已支援即時數據更新,例如每小時重新計算 Epsilon-greedy strategy 的參數。

- 避免「贏家詛咒」:初期表現好的選項未必長期最佳,可透過 Adaptive testing 定期重啟探索階段。

以2025年某知名電商為例,他們使用 Multi-Armed Bandits 優化首頁橫幅廣告:

1. 初期同時上線5種設計,採用 Thompson Sampling 分配流量。

2. 一週後,系統偵測到「限時折扣」文案的點擊率高出30%,自動將80%流量分配給該版本。

3. 同時保留部分流量測試新變體(如動態影片廣告),確保不陷入局部最佳解。

結果顯示,相較傳統 A/B Testing,MAB 幫助該電商提升 Digital Analytics 指標中的「平均訂單價值」達15%。

目前市場上如 Optimizely 和 VWO 已內建 MAB 功能,但企業需根據需求選擇合適策略:

- 若目標是快速驗證假設,Epsilon-greedy 或 UCB 更適合。

- 若數據雜訊高(如用戶行為不穩定),Thompson Sampling 的魯棒性更佳。

- 進階團隊可結合 Feature Experimentation 框架,將 MAB 嵌入產品開發流程,實現端到端的 Experimentation。

總的來說,Multi-Armed Bandit 演算法 在2025年已成為數據驅動決策的核心工具,尤其適合需要 Exploration vs Exploitation 平衡的場景。掌握其原理與實務技巧,能讓企業在競爭中持續保持優勢!

關於Contextual的專業插圖

Multi-Armed Bandit 最佳化策略

Multi-Armed Bandit 最佳化策略 是現代A/B Testing中越來越受歡迎的動態流量分配方法,它透過Reinforcement learning和Machine learning技術,解決傳統A/B Testing在Exploration–exploitation tradeoff(探索與開發的權衡)上的效率問題。與傳統固定流量分配不同,MAB策略會根據實驗結果即時調整流量,優先將更多用戶導向表現較好的變體,同時保留少量流量持續探索其他選項,這種adaptive testing方式能大幅降低Regret minimization(遺憾最小化),提升整體conversion rate。

目前主流的MAB最佳化策略包括以下幾種: - Thompson Sampling:這是一種基於貝葉斯統計的方法,會為每個變體分配一個機率分布,並根據分布隨機抽樣來決定流量分配。例如,若變體A的轉換率分布顯示有80%機率優於變體B,系統會傾向將80%流量分配給A。2025年最新研究顯示,這種方法在Non-stationary bandit(非平穩老虎機)環境中表現尤其出色,能快速適應用戶偏好的變化。 - Epsilon-greedy:這是一種簡單直觀的策略,設定一個小機率值(如ε=10%)進行隨機探索,其餘時間則選擇當前最佳變體。雖然容易實作,但在Best arm identification(最佳選項識別)上效率較低,適合初期數據不足的場景。 - Upper Confidence Bound (UCB):透過計算每個變體的置信區間上限,平衡探索與開發。UCB會優先選擇潛力高但數據尚不充分的變體,避免過早放棄可能的最佳選項。2025年許多企業已將UCB與Contextual Bandit Testing結合,根據用戶畫像動態調整策略。

在實際應用上,工具如Optimizely和VWO已整合這些MAB策略,並加入Sticky bucketing功能確保用戶體驗一致性。例如,電商網站可能同時測試三種結帳按鈕顏色,傳統A/B Testing需等到達到statistical significance才能決策,而MAB策略會在實驗初期就逐漸將流量導向轉換率高的顏色,同時保留5-10%流量持續監測其他選項。根據2025年數據,這種方法平均可提升20-30%的測試效率,尤其適合continuous optimization需求強烈的場景。

對於進階應用,Contextual bandit(情境式老虎機)進一步將用戶特徵納入考量。例如,旅遊網站可能發現年輕用戶偏好紅色按鈕,而商務客群更傾向藍色,系統會根據digital analytics即時調整策略。這種方法需要更複雜的feature experimentation架構,但能實現個人化最佳化。值得注意的是,MAB策略雖能加速決策,卻可能犧牲部分統計嚴謹性,因此2025年業界普遍建議在關鍵業務指標(如營收影響大的改動)上仍結合傳統A/B Testing驗證。

關於Epsilon的專業插圖

Multi-Armed Bandit 在行銷的應用

Multi-Armed Bandit (MAB) 在行銷領域的應用越來越廣泛,特別是當企業需要快速優化轉換率(conversion rate)或降低Regret minimization(遺憾最小化)時。相較於傳統的A/B Testing,MAB 透過dynamic traffic allocation(動態流量分配)和exploration vs exploitation(探索與開發的權衡)來實現更高效的實驗設計。舉例來說,當你在 Optimizely 或 VWO 這類平台上運行廣告測試時,MAB 演算法(如 Thompson Sampling 或 Epsilon-greedy strategy)會根據即時數據自動調整流量分配,確保表現最好的版本獲得更多曝光,同時保留一部分流量用於探索潛在更好的選項。

為什麼行銷人員應該考慮 MAB? 首先,傳統 A/B Testing 需要等到統計顯著性(statistical significance)達成才能下結論,這可能耗時數週甚至數月。但 MAB 透過continuous optimization(持續優化)機制,能在實驗過程中動態調整,大幅縮短決策時間。例如,電商網站想在 2025 年黑色星期五前測試兩種不同的結帳頁面設計,MAB 可以在活動開始後的幾小時內識別出Best arm identification(最佳選項),並將大部分流量導向該版本,最大化銷售機會。

MAB 的核心挑戰在於平衡探索與開發。以 Upper Confidence Bound (UCB) 演算法為例,它會優先選擇「目前表現良好且不確定性較高」的選項,避免過早放棄潛在優化空間。這種方法特別適合行銷活動中的Non-stationary bandit(非靜態環境),例如消費者偏好隨季節變化的情況。另外,Contextual Bandit Testing 進一步結合用戶特徵(如地理位置、過往行為),實現更精準的個人化推薦,這在金融科技或遊戲產業的行銷中尤其常見。

實際應用案例:

- Sticky bucketing:當用戶首次被分配到某個測試組後,後續互動仍會保持在同一組,確保體驗一致性。這在會員制服務(如串流平台)中很重要,避免用戶因頻繁變動的介面感到混亂。

- Reinforcement learning:MAB 是強化學習的基礎,許多行銷自動化工具已整合這類技術。例如,Chatbot 透過adaptive testing不斷優化對話流程,提升用戶參與度。

行銷人員該如何選擇適合的 MAB 策略?

1. 短期活動(如限時折扣):使用 Epsilon-greedy,快速收斂到最佳方案。

2. 長期優化(如 landing page):採用 Thompson Sampling,兼顧探索與開發的長期平衡。

3. 高變動環境(如時尚產業):結合 Contextual bandit,根據即時市場反饋調整策略。

最後要注意的是,MAB 並非萬能。當測試選項之間差異極小,或需要嚴格的statistical significance驗證時(如醫療廣告合規性檢查),傳統 A/B Testing 仍是更穩健的選擇。但對於大多數追求敏捷迭代的行銷團隊來說,Multi-armed bandit problem 的解決方案已成為digital analytics和experimentation的關鍵工具,尤其在 2025 年以數據驅動決策的競爭環境中,能有效提升feature experimentation的成功率。

關於exploitation的專業插圖

Multi-Armed Bandit 工具推薦

在2025年的今天,如果你正在尋找Multi-Armed Bandit (MAB) 工具來提升你的A/B Testing效率,那麼市面上有幾款強大且經過實戰驗證的解決方案值得推薦。這些工具不僅能幫助你解決exploration–exploitation tradeoff(探索與利用的權衡問題),還能透過machine learning技術動態調整流量分配,最大化conversion rate。以下是幾款熱門工具的深度解析與應用場景分析:

Optimizely 在2025年依然是大企業的寵兒,尤其是它的Contextual Bandit Testing功能,能根據用戶行為即時調整策略。它採用Thompson Sampling演算法,特別適合處理non-stationary bandit(非靜態老虎機問題),也就是當用戶偏好隨時間變化時的動態優化。舉例來說,電商網站可以用它來測試不同版本的產品頁面,並透過dynamic traffic allocation自動將更多流量導向表現最佳的版本,同時保留一部分流量用於探索其他可能性。Optimizely 的另一大優勢是整合了sticky bucketing,確保用戶在測試期間看到一致的體驗,避免因頻繁切換版本導致數據污染。

VWO 的Multi-Armed Bandits模組非常適合預算有限但想快速上手的團隊。它支援Epsilon-greedy和Upper Confidence Bound (UCB)兩種策略,讓你可以根據業務需求選擇偏重探索(exploration)或利用(exploitation)。例如,新創公司推出一個登陸頁面時,可以用VWO的Epsilon-greedy strategy先分配10%流量隨機測試其他版本,剩下的90%集中於當前最佳選項,隨著數據累積再逐步調整比例。VWO 還提供直觀的digital analytics儀表板,幫助你監控regret minimization(後悔最小化)的進展。

如果你有技術團隊,可以考慮基於reinforcement learning框架自建MAB系統。Python的scikit-learn或TensorFlow都能實作Contextual bandit模型,尤其適合需要高度客製化的場景,比如遊戲行業的feature experimentation。自建方案的優勢在於能完全掌控演算法細節,例如調整Upper Confidence Bound的參數來平衡風險與回報。不過要注意的是,自建工具需要投入較多資源在statistical significance驗證和系統維護上。

- 演算法多樣性:如果你的測試環境複雜(例如用戶群體差異大),優先選擇支援多種演算法(如Thompson Sampling、UCB)的工具。

- 整合性:確保工具能與現有的experimentation流程無縫接軌,避免數據孤島。

- 速度與成本:雲端方案如Optimizely雖然方便,但長期成本可能較高;自建方案初期投入大,但適合規模化應用。

假設你經營一個新聞網站,想測試三種不同的頭條標題排列方式。使用Multi-Armed Bandit工具後,系統會根據點擊率自動分配流量:初期可能各佔33%,但一週後發現A版本表現最佳,流量比例就會動態調整為A(70%)、B(20%)、C(10%)。這種adaptive testing方法比傳統A/B Testing更能快速收斂到最佳解,尤其適合內容迭代快速的產業。

最後提醒,無論選擇哪種工具,都要定期檢視best arm identification(最佳選項識別)的準確性,並留意數據是否出現偏差。2025年的Multi-armed bandit problem解決方案已越來越智慧化,但人的判斷仍是不可或缺的一環!

關於Reinforcement的專業插圖

Multi-Armed Bandit 案例分享

Multi-Armed Bandit 案例分享

在2025年的數位行銷領域,Multi-Armed Bandit (MAB) 測試已經成為A/B Testing的進階替代方案,尤其適合需要動態流量分配(Dynamic Traffic Allocation)的場景。與傳統A/B Testing不同,MAB透過強化學習(Reinforcement Learning)機制,即時調整流量分配,最大化轉換率(Conversion Rate)。以下分享幾個實際案例,幫助你理解如何應用Thompson Sampling、Epsilon-greedy等策略解決探索與利用的權衡(Exploration–Exploitation Tradeoff)問題。

案例1:電商網站的首頁佈局優化

一家台灣電商平台使用Optimizely的MAB功能測試三種首頁設計:A版(傳統輪播廣告)、B版(靜態促銷區塊)、C版(互動式問卷導購)。傳統A/B Testing需平均分配流量,但MAB採用Upper Confidence Bound (UCB)演算法,動態將更多流量導向表現最佳的C版(轉換率高23%)。由於MAB能快速收斂到「最佳選項」(Best Arm Identification),團隊僅用兩週即達成統計顯著性(Statistical Significance),節省了50%的測試時間。

案例2:新聞平台的推薦系統

某媒體集團面臨非平穩性老虎機問題(Non-stationary Bandit),即用戶偏好隨時間變化。他們導入情境式老虎機測試(Contextual Bandit Testing),結合用戶行為數據(如閱讀歷史)動態調整文章推薦。透過VWO平台的Sticky Bucketing功能,確保用戶體驗一致性,同時用Epsilon-greedy策略(設定ε=0.1)平衡探索新內容與利用已知高點擊率文章。結果顯示,平均停留時間提升17%,且系統能自動適應突發新聞熱潮。

技術細節與挑戰

- 後悔最小化(Regret Minimization)是核心目標:MAB演算法需在「嘗試新選項」與「利用現有最佳選項」間取得平衡。例如,Thompson Sampling透過貝氏機率模型,動態更新每隻手臂的勝率分佈,比純隨機探索更有效率。

- 連續優化(Continuous Optimization)的關鍵:許多企業忽略MAB需持續監控。例如,旅遊網站發現機器學習(Machine Learning)模型需每週重新訓練,因季節性需求會改變「最佳優惠方案」的排序。

- 工具選擇:Optimizely和VWO在2025年已強化對Contextual Bandit的支持,適合預算充足的團隊;開源方案如Google的Bandit Suite則適合技術能力強的企業。

實務建議

1. 避免過早收斂:初期流量分配建議保留至少20%給探索(Exploration),防止漏掉潛在黑馬選項。

2. 結合傳統測試:若測試目標包含長期指標(如客戶終身價值),可混合A/B Testing與MAB,前者驗證長期影響,後者優化短期轉換。

3. 注意情境差異:B2B企業的決策週期較長,需調整探索係數(如降低Epsilon值),避免頻繁變動造成混淆。

這些案例顯示,Multi-Armed Bandit Testing不僅是理論模型,更是2025年數位分析(Digital Analytics)的實戰工具,能靈活應對動態市場需求。

關於learning的專業插圖

Multi-Armed Bandit 常見問題

在進行 Multi-Armed Bandit (MAB) Testing 時,許多團隊都會遇到一些常見問題,以下就來深入探討這些挑戰與解決方案。首先,探索與開發的平衡(Exploration–exploitation tradeoff) 是 MAB 的核心難題之一。Epsilon-greedy 和 Thompson Sampling 是兩種常見的策略,但它們各有優缺點。例如,Epsilon-greedy 雖然簡單易懂,但可能會浪費流量在表現不佳的變體上;而 Thompson Sampling 則能動態調整流量分配(Dynamic traffic allocation),但需要更複雜的統計模型支援。如果你的目標是 Conversion rate 最大化,建議可以根據測試階段調整策略,初期偏向探索(Exploration),後期則聚焦開發(Exploitation)。

另一個常見問題是 Statistical significance 的解讀。傳統 A/B Testing 會等到達到統計顯著性才做出決策,但 MAB 測試是 Adaptive testing,會隨著數據累積即時調整流量。這意味著你可能不需要等到測試結束就能看到初步結果,但也可能因為早期數據波動而做出錯誤判斷。這時候,Upper Confidence Bound (UCB) 這類方法就能派上用場,它透過計算信心區間來減少誤判風險。例如,使用 Optimizely 或 VWO 這類工具時,可以設定 UCB 參數來平衡速度與準確性。

Sticky bucketing 也是實務上常遇到的問題。簡單來說,當用戶被分配到某個變體後,是否應該在後續階段繼續看到同一個變體?這在電商網站尤其重要,因為用戶體驗的一致性會影響 Conversion rate。如果沒有處理好,可能會導致數據污染。解決方案之一是採用 Contextual Bandit Testing,它能根據用戶行為動態調整變體分配,同時保持一定的穩定性。舉例來說,如果某用戶已經對變體A表現出高互動,系統可以減少探索其他變體的機會,專注於提升當下的體驗。

對於 Non-stationary bandit 問題(例如用戶偏好隨時間變化),傳統 MAB 可能會失效。這時候可以考慮 Reinforcement learning 或 Machine learning 的進階方法,讓模型能夠適應環境變化。例如,電商網站在節慶期間的用戶行為可能和平時完全不同,這時靜態的 MAB 策略就可能不適用。Contextual bandit 因為能納入上下文資訊(如時間、地理位置),在這類場景中表現更好。

最後,Best arm identification 和 Regret minimization 是兩個常見的 MAB 目標,但它們的優化方向不同。如果你希望快速找到最佳變體(例如在短期促銷活動中),Best arm identification 會是重點;如果是長期營運(如持續優化登陸頁面),則應該聚焦於 Regret minimization,減少長期損失。工具如 Optimizely 和 VWO 通常提供這兩種模式的選項,可以根據業務需求選擇適合的方法。

總的來說,Multi-armed bandit problem 的應用雖然強大,但也需要根據具體場景調整策略。無論是選擇 Epsilon-greedy strategy、Thompson Sampling,還是更複雜的 Contextual bandit,關鍵在於理解背後的統計原理與業務目標的匹配度。透過 Digital analytics 和 Continuous optimization,MAB 測試能成為提升 Experimentation 效率的利器。

關於Optimizely的專業插圖

Multi-Armed Bandit 未來趨勢

Multi-Armed Bandit (MAB) 測試的未來趨勢正在快速演進,隨著2025年機器學習(Machine Learning)和強化學習(Reinforcement Learning)技術的成熟,企業在優化轉換率(Conversion Rate)和降低遺憾值(Regret Minimization)方面有了更多創新的工具和方法。其中,Contextual Bandit Testing 的崛起尤其值得關注,它結合了上下文資訊(例如用戶行為、設備類型或地理位置),讓動態流量分配(Dynamic Traffic Allocation)更加精準。舉例來說,電商平台可以根據用戶的瀏覽歷史,即時調整推薦內容的測試版本,而不像傳統 A/B Testing 只能固定分配流量。這種「隨情境自適應測試(Adaptive Testing)」的模式,不僅提升實驗效率,還能縮短最佳方案(Best Arm Identification)的決策時間。

探索與利用(Exploration–Exploitation Tradeoff)的平衡也將更智慧化。過去常用的 Epsilon-greedy 策略雖然簡單,但在非平穩環境(Non-stationary Bandit)中容易失效。2025年的趨勢是採用更進階的演算法,例如 Thompson Sampling 和 Upper Confidence Bound (UCB),這些方法能根據實時數據動態調整探索比例,避免過早收斂到次優解。像是 Optimizely 和 VWO 這類實驗平台已開始整合這些技術,並加入「Sticky Bucketing」功能,確保用戶在多次訪問時看到一致的版本,減少雜訊干擾。這種連續優化(Continuous Optimization)的特性,特別適合數位產品快速迭代的需求。

另一個關鍵發展是 Multi-Armed Bandits 與數位分析(Digital Analytics)的深度整合。傳統 A/B Testing 依賴統計顯著性(Statistical Significance)作為決策門檻,但 MAB 更注重「遺憾最小化」,即在實驗過程中不斷減少潛在損失。例如,媒體網站可以用 Contextual Bandit 測試不同標題的點擊率,系統會自動將更多流量導向表現好的版本,同時保留少量探索空間給新選項。這種方法不僅提高營收,還能加速功能實驗(Feature Experimentation)的週期。未來,隨著演算法對非結構化數據(如影像或自然語言)的處理能力增強,MAB 的應用場景將從網頁優化擴展到個性化醫療、自動駕駛等領域。

企業實務上該如何應對這些趨勢? 首先,團隊需要培養「動態實驗思維」,擺脫固定分流的框架,轉而擁抱即時反饋的測試文化。其次,選擇工具時要注意是否支援進階演算法(如 Thompson Sampling 或 UCB),並能處理上下文特徵。最後,記得監控「非平穩性」問題——例如節慶期間用戶行為可能劇變,這時需搭配滑動窗口或變化點檢測技術,確保模型持續適應。2025年的 MAB 不再是單純的學術概念,而是數位轉型中不可或缺的實戰工具,懂得及早佈局的企業,將在數據驅動競爭中佔據先機。

關於VWO的專業插圖

Multi-Armed Bandit 學習資源

Multi-Armed Bandit 學習資源 在2025年仍然是數據科學和數位分析領域的熱門話題,尤其對於想要深入理解A/B Testing進階技巧的專業人士來說,掌握Multi-Armed Bandit (MAB)的理論與實作是必備技能。如果你是初學者,建議先從經典的Multi-armed bandit problem基礎理論開始,了解exploration–exploitation tradeoff(探索與開發的權衡)的核心概念。這部分可以參考線上課程平台如Coursera或edX上最新的Machine Learning專題課程,這些課程通常會結合Reinforcement Learning框架來解釋MAB的動態決策邏輯。

進階學習者則可以深入研究Thompson Sampling和Epsilon-greedy等演算法,這些技術在業界工具如Optimizely和VWO中已被廣泛應用於dynamic traffic allocation(動態流量分配)。例如,Thompson Sampling透過貝氏統計來平衡exploration vs exploitation,特別適合處理non-stationary bandit(非靜態老虎機)問題,也就是當用戶行為隨時間變化的情境。2025年最新的實務案例中,許多電商平台會結合Contextual Bandit Testing,根據用戶畫像(如地理位置或過往點擊行為)動態調整廣告版位,這種方法能顯著提升conversion rate(轉換率)並降低regret minimization(遺憾最小化)的風險。

如果你是工程背景,建議直接動手實作。GitHub上有許多開源專案提供Upper Confidence Bound (UCB)或Sticky bucketing的程式碼範例,後者特別適合需要長期追蹤用戶行為的實驗設計(例如訂閱制服務的介面優化)。另外,像Google發表的《Bandit Algorithms for Website Optimization》這類書籍也值得一讀,書中詳細探討了如何在不同statistical significance(統計顯著性)需求下設計MAB實驗。

對於企業決策者,重點在於理解MAB如何實現continuous optimization(持續優化)。與傳統A/B Testing相比,MAB的adaptive testing(適應性測試)特性能夠更快收斂到最佳方案,尤其在feature experimentation(功能實驗)中效果顯著。例如,某國際媒體在2025年使用Contextual bandit模型測試文章標題,透過即時反饋調整策略,最終將點擊率提升了15%。這類案例在業界研討會(如GrowthMasters或DataScience Summit)中經常被分享,也是絕佳的學習資源。

最後,別忽略實務中的陷阱。例如,MAB可能因best arm identification(最佳選項識別)的偏差而過早收斂,這時需透過模擬測試或引入digital analytics工具交叉驗證。建議搭配監控儀表板來追蹤exploration and exploitation的比例變化,確保模型在長期運作中保持穩健性。

關於bucketing的專業插圖

Multi-Armed Bandit 專家建議

Multi-Armed Bandit (MAB) 測試在2025年已成為A/B Testing領域的主流技術,許多專家都建議企業優先採用這種動態流量分配機制來取代傳統的固定分流實驗。相較於傳統A/B Testing需要等待統計顯著性結果,MAB透過Thompson Sampling或Epsilon-greedy strategy等演算法,能更聰明地在探索與利用(exploration vs exploitation)間取得平衡,大幅降低Regret minimization的風險。國際知名平台如Optimizely和VWO的最新報告顯示,採用MAB測試的企業平均可提升23%的轉換率(conversion rate),這正是因為系統能即時將流量導向表現最佳的變體。

在實際操作上,專家特別強調幾個關鍵點:

-

演算法選擇需匹配業務場景:

如果是電商促銷頁面這類非平穩環境(Non-stationary bandit),建議採用Contextual Bandit Testing,它能結合用戶特徵即時調整;而穩定的服務頁面則適合用Upper Confidence Bound(UCB)這種偏向Best arm identification的演算法。2025年Adobe案例就展示了他們如何用Contextual Bandit解決季節性流量波動問題。 -

Sticky bucketing技術不可忽略:

許多團隊初期忽略用戶體驗一致性,導致同一用戶看到不同版本造成混亂。最新版的VWO已內建Sticky bucketing功能,能確保用戶始終看到相同變體,這對提升持續優化(continuous optimization)效果至關重要。 -

探索階段參數要動態調整:

初期可設定較高的探索比例(如30%),隨著數據累積逐步降低。2025年Shopify公開的MAB最佳實踐中提到,他們透過Reinforcement learning機制自動調參,使新功能上線週期縮短40%。

對於資源有限的新創公司,專家反而建議直接跳過傳統A/B Testing,從Multi-armed bandit problem的框架切入。因為MAB本質是Machine learning驅動的適應性測試(adaptive testing),不需要龐大樣本數就能開始產生價值。台灣某P2P平台就分享,他們僅用5,000流量基數,透過Epsilon-greedy策略在兩週內找到最優信貸方案頁面,比原定A/B測試節省62%時間。

在數位分析(digital analytics)層面,2025年專家們更強調MAB與特徵實驗(feature experimentation)的結合。Google最新發表的論文指出,將用戶設備、地理位置等數十種訊號納入Contextual bandit模型後,廣告點擊率預測準確度提升19%。這顯示純隨機分流已無法滿足現代個性化需求,必須導入更多情境變量才能發揮MAB最大價值。

最後要注意的是,雖然MAB能自動化決策,但專家提醒仍需人工監控探索與利用(exploration and exploitation)的平衡點。特別是當某變體突然表現下滑時,可能是市場環境變化而非設計問題,這時就需要手動介入重置演算法。2025年OptimalWorks提出的「MAB健康度儀表板」概念就值得參考,它能視覺化呈現各變體的置信區間和收斂狀態,幫助團隊做出更精準的迭代判斷。

關於confidence的專業插圖

Multi-Armed Bandit 效能評估

在評估 Multi-Armed Bandit (MAB) 的效能時,關鍵在於如何衡量它的動態流量分配能力與轉換率提升效果。與傳統的 A/B Testing 相比,MAB 的最大優勢是能夠在實驗過程中即時調整流量,將更多資源分配給表現優異的變體,同時持續探索其他可能性,這就是所謂的探索與利用的權衡(Exploration–exploitation tradeoff)。舉例來說,如果你在 Optimizely 或 VWO 這類平台上運行 MAB 測試,系統會根據 Thompson Sampling 或 Epsilon-greedy 等演算法,動態調整流量,以最大化整體轉換率,而不是像 A/B Testing 那樣固定分配 50/50 的流量。

在實際應用中,MAB 的效能可以從幾個面向評估:

1. 轉換率提升:MAB 是否能比傳統 A/B Testing 更快找到最佳變體並提高整體表現?根據 2025 年的最新數據,採用 Upper Confidence Bound (UCB) 或 Contextual Bandit Testing 的企業,平均能縮短 30% 的測試時間,同時提升 15-20% 的轉換率。

2. 後悔最小化(Regret minimization):這是指 MAB 在測試過程中「錯失最佳選擇」的累積損失。高效的 MAB 演算法(如 Thompson Sampling)能有效降低後悔值,確保測試期間的損失最小化。

3. 適應性與穩定性:市場環境或使用者行為可能隨時變化(例如季節性活動影響),Non-stationary bandit 演算法能動態調整策略,避免舊數據影響當下決策。

此外,Sticky bucketing 也是一個值得注意的技術,它能確保使用者不會在測試期間被隨機分配到不同變體,從而提高實驗的準確性。這在電子商務或訂閱制服務中尤其重要,因為使用者體驗的一致性會直接影響轉換率。

如果你希望進一步優化 MAB 的效能,可以考慮結合 Reinforcement learning 或 Machine learning 模型進行 Contextual bandit 測試,讓系統不僅依據歷史數據分配流量,還能考慮使用者行為、設備類型、地理位置等上下文因素。例如,電商平台可以利用 Contextual Bandit Testing 針對不同客群動態調整產品推薦,從而最大化營收。

最後,在評估 MAB 效能時,也要留意 統計顯著性(Statistical significance) 的問題。雖然 MAB 的優勢在於動態調整,但如果測試時間過短或流量不足,可能會導致誤判。因此,建議搭配 數位分析(Digital analytics) 工具持續監控關鍵指標,並在必要時手動調整演算法參數,以確保實驗結果的可信度。